近日,美光团队在 NVIDIA GTC 大会上展示了业界前沿的 AI 内存和存储产品组合。这些产品引起了参展商和与会者的极大兴趣和广泛关注,本博客介绍了其中的一些细节。美光内存正在推动和引领面向未来的 AI 技术,我们来一起了解下吧。

助力未来 AI 技术更强大、更智能

人类正在进入一个新的时代:虚拟世界和真实世界的边界日趋模糊,且深度交织。未来,推动世界向前发展的不仅包括当下热门的 CPU 和 GPU 算力,还包括默默无闻的幕后英雄:内存和存储芯片。这些器件相互配合,共同加速人工智能 (AI) 的发展,使 AI 融入人们日常生活的方方面面。其中内存更是 AI 加速的关键,不仅能够帮助 AI 从海量数据集中学习,还将使未来人类与技术的交互更加直观、顺畅,显著提高 AI 的智能。

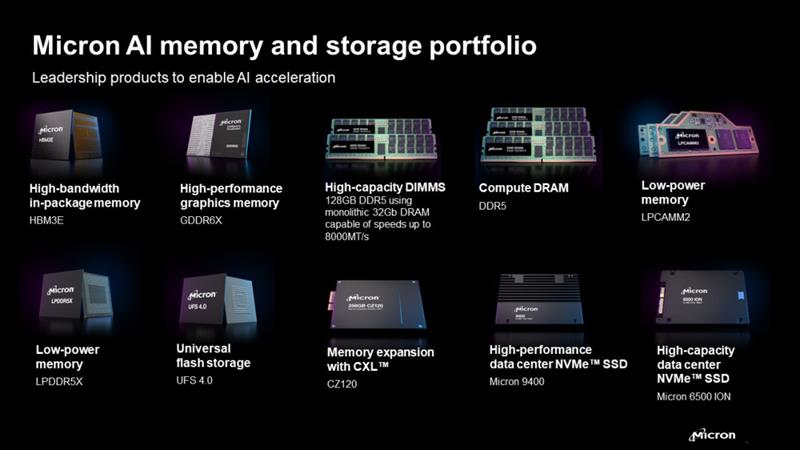

全球各经济体正在竞相追逐技术创新以及新技术的应用。以美光为例,从业界前沿的 232 层 NAND 技术和 1 (1-beta) DRAM 创新,到 NVIDIA H200 Tensor Core GPU 中部署的美光 HBM3E 内存,我们见证了技术进步如何助推半导体制造和先进封装领域取得诸多成就,并推动 AI 迈向超级互联的未来。美光 AI 产品组合中的每一次创新和突破,都让我们向着更加智能的 AI 时代迈进了一步,这标志着内存将成为未来 AI 革命的基石。

未来的 AI 不仅能够模仿现实,还能进一步增强现实,内存和半导体则是这一过程的硬件基础。这是一段创新之旅,过往经验证明,要想突破现有 AI 的局限,硬件技术发展必不可少。了解硬件的关键作用,有助于我们进一步推动技术发展,为未来创造更多的可能性。

我之所以写这篇博客,是因为我曾有幸领导美光的企业营销团队,在 20 个月内推出了一些突破性产品,大幅加速了 AI 的发展。我们与产品负责人、销售人员、工程师和业务经理携手合作,一直位于产品开发的最前沿,直至推出这些创新产品,并围绕这些产品展开了讨论。这段经历让我深刻理解了如何营销业界前沿的产品,以及美光的技术如何塑造 AI 的未来。

AI 层次结构:架构智能

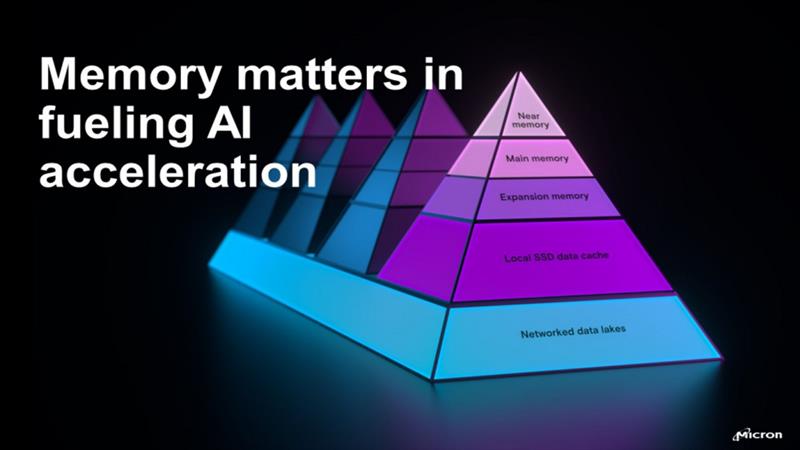

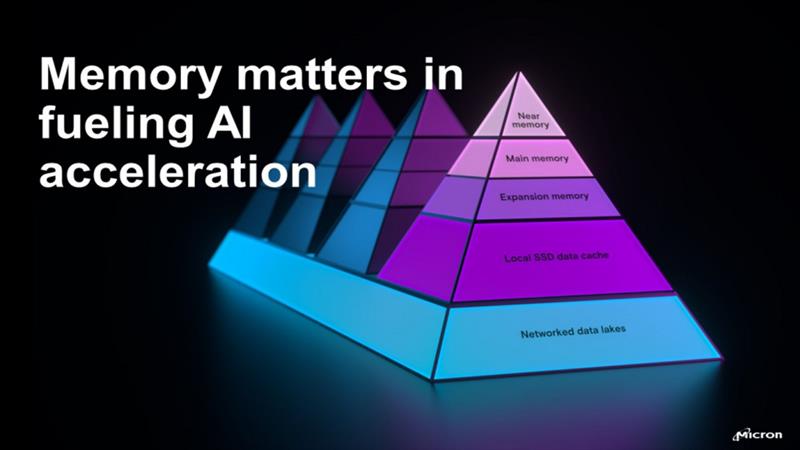

信息图表:AI 内存和存储技术层次结构

在 AI 相关硬件中,内存和存储层次结构并非仅是 GPU 和 CPU 的补充,更是决定 AI 能力和潜力的关键。近内存位于顶部,包括美光的高带宽内存 (HBM) 解决方案 HBM3E 等技术。该层用于直接高速处理与 CPU 或 GPU 相邻的数据,可大幅减少延迟并增加带宽。借助近内存硬件,AI 能够以前所未有的效率执行复杂的计算并处理大量数据,对于实时分析和决策应用至关重要。

近内存层下方是主内存层,主要包括美光单颗粒大容量 DDR5 DIMM 等产品。这一层是 AI 计算的主力,除了出众的速度之外,还需要有管理大量数据的能力,以供 AI 算法分析使用。美光的高速度、低功耗 DDR5 为 AI 系统的运行提供了强大的平台,支持快速执行 AI 模型和模拟。

扩展内存层包括各种可扩展系统内存容量的解决方案,例如美光的 CZ120,采用 Compute Express Link (CXL) 技术,可提供远超传统内存的容量。这一层满足了 AI 应用不断增长的内存需求,能够训练和执行规模更大、复杂度更高的 AI 模型。扩展内存是一项关键创新,克服了传统内存架构的物理限制,使 AI 系统能够在不降低性能的前提下扩大处理能力。

扩展内存层下方是 SSD 数据缓存层,这是一种重要的中间存储解决方案,旨在让应用快速访问常用数据。数据缓存层能够加速数据检索过程,确保 AI 应用不会因数据访问时间过长而卡顿。美光的旗舰 SSD(如 9000 和 7000 系列)可用于数据缓存层,其快速存储能力可大幅缩短 AI 应用的响应时间,提高效率。

金字塔的底部是数据湖,也称为基础数据存储层。数据湖中包含多个巨大的原始数据池,可为 AI 算法提供训练和分析所用的数据。高效存储和管理这些数据的能力,对于 AI 发展举足轻重。美光 6000 SSD 系列等先进存储解决方案可用于该层,以应对 AI 生态系统中呈指数级增长的数据。在这种 AI 驱动的应用场景中,传统的机械硬盘 (HDD) 早已过时。

这些层紧密结合,共同构成了支持 AI 革命的底层结构,彰显出内存和存储技术在充分实现 AI 潜力方面不可或缺的作用。美光的行业前沿创新覆盖了这一层次结构中的每一层,让我们能够了解每一层在推动 AI 发展方面的独特作用。这些创新产品互相配合,让 AI 更加智能,更深入地融入人类的数字生活。

近内存:基于美光 HBM3E 的 AI 加速引擎

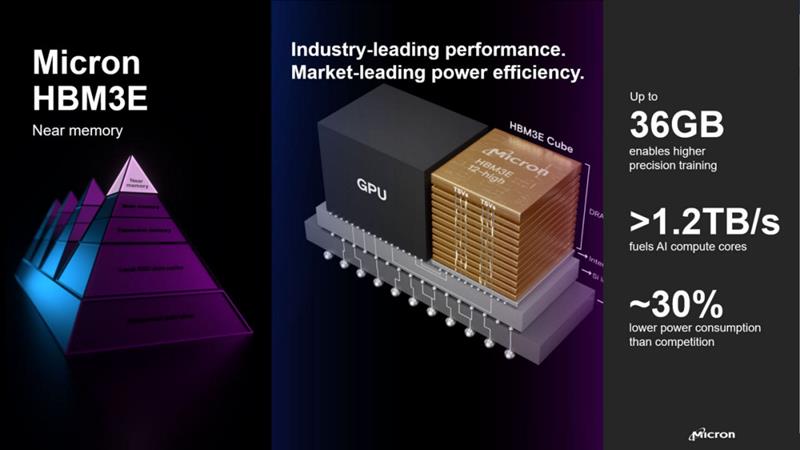

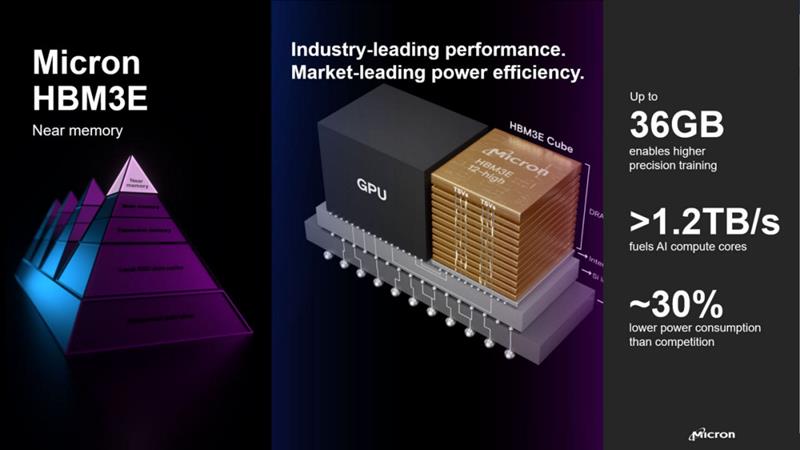

信息图表:美光 HBM3E 近内存的性能和功耗优势。

美光 HBM3E 是近内存创新的典型代表,可提供前所未有的速度和效率,对于大语言模型 (LLM) 和 AI 应用至关重要。HBM3E 能够克服内存瓶颈,让 AI 系统充分利用处理器的性能。随着 LLM 及相关数据集的规模呈指数级增长,近内存将愈发重要。

美光致力于突破内存容量和带宽的限制(提供 8 层堆叠 24GB HBM3E 和 12 层堆叠 36GB HBM3E 等解决方案)并实现业界前沿的能源效率,在近内存领域拥有明显的优势地位。与竞品相比,美光 HBM3E 的功耗降低 30%,可使 AI 应用更具可持续性,这是技术开发中日益关注的一个方面。

HBM3E 的推出,尤其是与 NVIDIA H200 Tensor Core GPU 的集成,标志着内存性能的划时代飞跃。HBM3E 可增强 AI 计算核心,并能够以更节能的方式实现 AI 加速。美光 HBM3E 为 AI 应用高效运行大模型奠定了基础,未来的 AI 可以突破当前内存限制,充分扩展。这些能力还有助于数据中心节约运营成本,减轻对环境的影响。

美光 HBM3E 的低功耗优势,对于未来大型 AI 数据中心的可持续发展至关重要。这种对未来需求的提前关注,展示了美光采用的前瞻性方法,即在满足 AI 研究和开发相关紧迫计算需求的同时,优先考虑可持续性和运营的成本效益。通过集成美光的低功耗 HBM3E 解决方案,AI 数据中心可节约大量运营成本。这一节约举措十分关键,因为高性能计算资源将消耗大量电力,意味着不菲的运营支出。对于大型云服务提供商而言,优先考虑能源效率可显著降低电力消耗和运营成本。因此,在大规模扩张 AI 基础设施的过程中,选择正确的内存技术非常重要。

此外,这一旨在提升 AI 计算可持续性的战略举措也符合整个行业的发展趋势,即逐步减轻大规模计算对环境的影响。美光在内存技术上的进步,不仅为前沿 AI 应用加速带来了所需的计算能力,还展示了技术创新如何与环境可持续发展目标保持一致。

这一转变反映了整个行业在追求更高性能的同时,更加注重能效和可持续性。美光目前正在送样 12 层堆叠 36GB HBM3E 解决方案,可为 AI 平台提供更高的容量。作为推动 AI 基础设施发展的明星产品,美光 HBM 将技术创新与注重环保的设计相结合,将在未来的 AI 时代大显身手。

主内存:美光单颗粒大容量 DDR5 助力 AI 服务器提升“大脑处理器”的计算能力

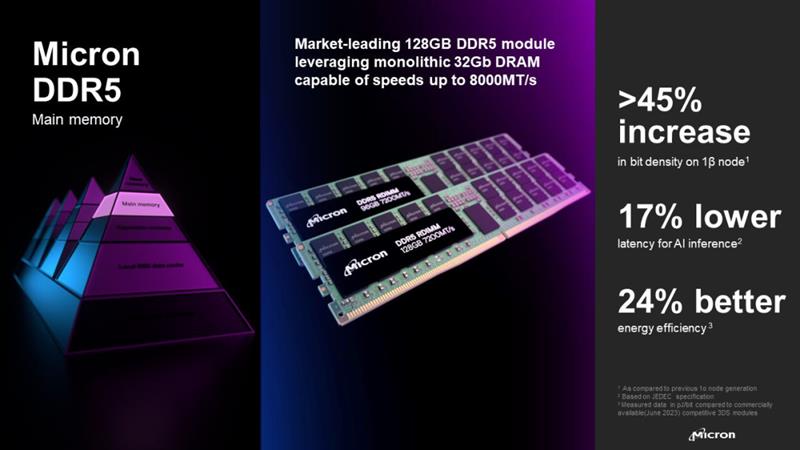

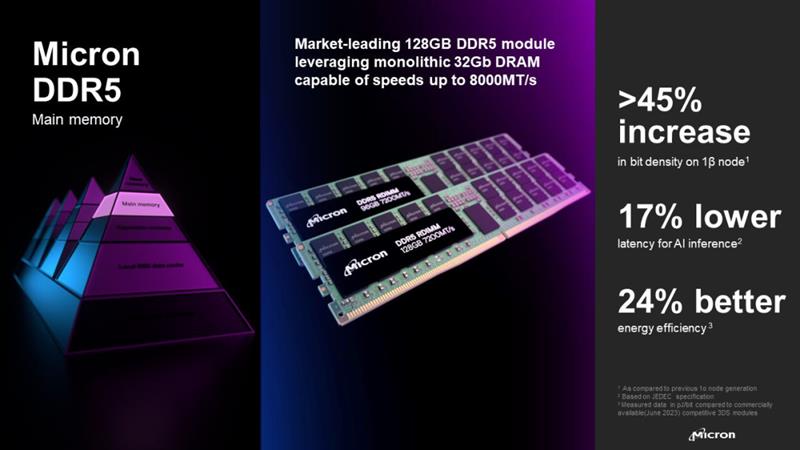

信息图表:美光 DDR5 主内存的性能和功耗优势。

美光的大容量 DDR5 主内存提供前所未有的速度和效率,已成为 AI 处理过程中不可或缺的组成部分,未来将继续引领 AI 加速。128GB DDR5 RDIMM 速度高达 8000 MT/s,采用美光业界前沿的 1 节点技术,位密度提高了 45% 以上。该产品具有划时代的性能和能源效率,可满足 AI 应用严苛的数据分析和处理需求。此外,该产品还可大幅提升 AI 系统的响应能力和决策速度,并将延迟降低 17%。

美光的 LPDDR5X 和 LPCAMM2 产品进一步丰富了 DDR5 生态系统,加强了 AI 的发展势头。LPDDR5X 的峰值带宽高达 9.6 Gb/s,较前代产品提升 12%,功耗降低了 30%,彰显出美光在低功耗内存创新领域的优势地位。美光 LPCAMM2 则为 AI PC 和数据中心的主内存带来了新范例。该产品速度高达 9600 Mb/s,功耗大幅降低,拥有更紧凑的模块化外形尺寸,可助力实现更高效、更强大的 AI 计算能力。

美光的大容量 DDR5 以及创新的 LPDDR5X 和 LPCAMM2 内存模块能够满足 AI 和机器学习工作负载不断提高的需求,标志着美光在内存技术上的巨大飞跃。这些创新技术提高了内存的速度和效率,降低了内存的功耗,这些特性对于全球主要云服务提供商至关重要。

当前,数据中心日益成为 AI 云服务的关键基础设施,在保持性能的前提下优化能源使用,比以往任何时候都更加重要。通过集成美光的前沿内存解决方案,大型云服务提供商能够以更加可持续的方式扩张其 AI 能力,同时确保更低的总拥有成本,并展现出他们的承诺:积极拥抱创新技术,推动整个科技行业迈向更高效、更强大、由 AI 驱动的未来。

扩展内存:美光 CZ120 助力突破内存限制

信息图表:美光 CZ120 扩展内存的性能优势。

扩展内存是 AI 内存和存储层次结构中的关键桥梁,帮助 AI 系统在不降低速度或效率的前提下处理更为复杂的工作负载。CXL 扩展内存模块位于主内存层和数据缓存层之间,是扩展内存层的创新产品,所提供的可扩展内存解决方案能够满足复杂 AI 应用的需求。该技术可在各种用例中实现无缝扩展和性能提升,展示出扩展内存技术在更广泛的 AI 技术开发领域产生的变革性影响。

美光 CZ120 内存扩展模块采用 CXL 技术,可满足 AI 和高性能计算对内存容量越来越高的需求,从而大幅提升了数据中心的 AI 支持能力。这些模块的速度高达 36 GB/s,提供 128GB 和 256GB 容量选择,可为复杂工作负载提供所需的内存容量和带宽,以此提升服务器的性能。扩展内存对于 AI 训练、软件即服务 (SaaS) 和内存数据库等应用至关重要,有望将计算效率提升到新水平。

为满足数据中心不断增长的需求,美光携手 Intel、AMD 等行业知名厂商,合作开发和测试了采用 CXL 技术的 CZ120 内存扩展模块。这一战略合作伙伴关系旨在促进 CXL 技术的普及,将服务器内存的效率和性能提升到新水平。美光通过技术支持计划,为合作伙伴提供广泛的支持和资源,确保基于 CXL 技术的内存扩展模块创新能够显著提高全球数据中心的数据处理能力和成本效益。

SSD 数据缓存:美光 9000 和 7000 系列数据中心 SSD 加速数据访问

信息图表:美光 7500 和 9400 SSD 展示。

在 AI 计算框架的层次结构中,本地 SSD 数据缓存层旨在快速访问存放在大容量存储设备上的海量数据信息。传统的 HDD 存储解决方案通常需要额外的设备协助,才能满足数据密集型 AI 工作负载所需的吞吐量,从而导致出现数据传输瓶颈,严重影响 AI 应用的性能。

如果这一瓶颈出现在数据中心内,后果尤为严重。从速度较慢的存储介质中获取数据时的延迟,可能会显著影响 AI 模型在实时决策过程中的效率。美光 9000 和 7000 系列 SSD 旨在解决这一挑战,其高速数据访问能力可毫无延迟地提供 AI 算法所需的数据,并确保整个 AI 计算过程顺畅高效。这些 SSD 拥有出众的效率和速度,可确保数据密集型 AI 应用(例如机器学习模型和复杂的分析)流畅运行,在减少延迟的同时提高 AI 应用的性能。

美光 9000 和 7000 系列 SSD 进一步提高了 SSD 数据缓存在 AI 工作负载中的重要作用,是消除数据访问瓶颈的关键解决方案。尤其是美光 9400 SSD,与主流竞品相比,其混合工作负载性能可提高 2.3 倍,能源效率提升高达 77%,为 PCIe 4.0 存储树立了新的性能基准。该系列 SSD 的容量高达 30.72TB,可为数据中心带来更高的存储密度和运营效率。这些优势可确保 AI 算法快速访问所需数据,加速实时处理和决策的过程。

凭借出众的性能和容量,美光 9400 SSD 已成为先进医疗诊断和 AI 增强客户体验等实际应用中的关键器件。该款 SSD 在 100% 4K 随机读取时每秒可完成 160 万次输入/输出操作 (IOPS),在混合读写工作负载中同样表现出色,可应对要求严苛的数据中心任务。美光 9400 SSD 不仅可以缩短机器学习和模型训练的时间,还可为高频交易和在线交易提供所需的速度和效率,是现代数据密集型工作负载的理想选择。

此外,美光 9400 SSD 的能源效率同样出众,可满足当今时代数据中心严格的功耗要求,提升高性能计算的可持续性。美光 9400 SSD 拥有更高的每瓦 IOPS,可为数据中心带来更高的能源吞吐量,降低数据中心的运营费用以及对环境的影响。美光致力于推动存储技术发展,以满足 AI 和云计算越来越高的要求。作为美光推出的重要解决方案,美光 9400 SSD 实现了性能、容量和功耗的平衡,能够解决 AI 环境中长期存在的存储挑战。

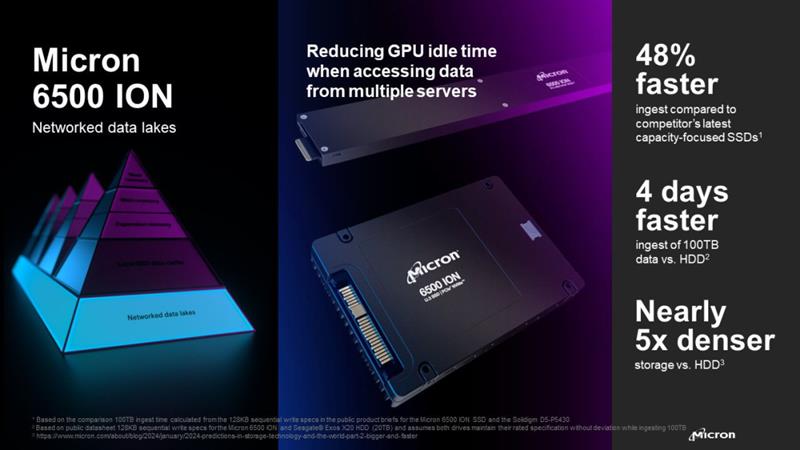

网络数据湖:美光 6000 系列数据中心 SSD 为 AI 奠定基础

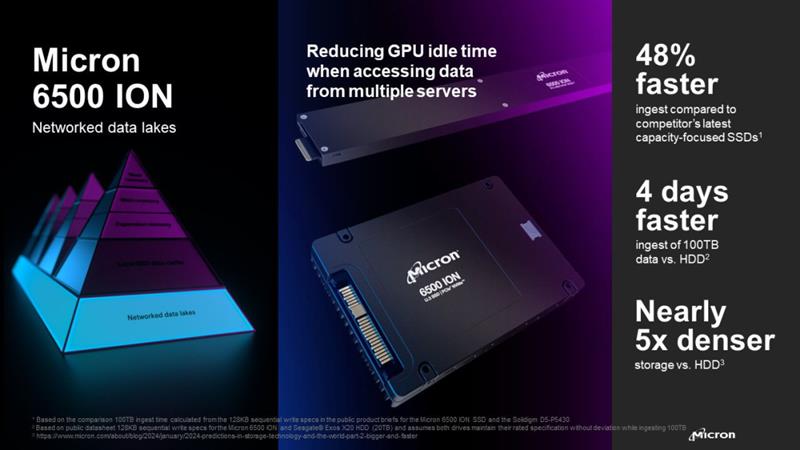

信息图表:展示美光 6500 ION SSD 的性能、速度和存储密度。

数据湖是 AI 生态系统中不可或缺的一部分,用于存储 AI 应用所需的海量数据。数据湖是 AI 应用的基石,它提供巨大的存储空间,能够确保数据随时可用,可供许多 AI 处理流程同时访问。数据湖以原生格式聚合来自不同来源的数据,供 AI 应用进行更全面的数据分析和机器学习,并为 AI 预测性洞察和决策提供所需的原始材料。

数据湖可存储和管理大量非结构化数据,对于希望利用 AI 技术获得竞争优势的企业而言,数据湖是必不可少的存储基础设施。美光 6000 系列数据中心 SSD 确保数据能够安全存储并易于访问,进一步增强了这一基础层,支持动态 AI 计算所必需的快速数据检索能力。

美光 6500 ION 系列数据中心 SSD 提供至关重要的解决方案,让 AI 应用能够快速可靠地访问底层的数据存储库。6500 ION 系列是全球首款 200+ 层 NAND 数据中心 NVMe SSD,拥有远超前代产品和竞品的性能、安全性和能效,为数据存储树立了新标准。

性能基准测试显示,6500 ION 拥有出众的效率,在处理不同的工作负载时均表现出显著优势。例如,在 Ceph 对象存储工作负载中,6500 ION 的顺序写入性能比同类产品高出 3.5 倍,随机读取性能高出 49%。此外,6500 ION 也适用于 Cassandra 等 NoSQL 数据库应用程序,在读取密集型任务中,峰值性能比同类产品高出 2.6 倍,是数据中心的理想选择,可帮助管理要求严苛的复杂工作负载。

美光 6500 ION 在性能、效率和可持续性方面均表现出色。凭借高达 30.72TB 的容量,以及在功耗和散热方面的提升,6500 ION 可大幅提高服务器的存储密度,从而减少资本支出、运营支出和碳排放。6500 ION 兼具高性能、大容量和高效率,彰显出美光的承诺:提升数据中心的能力,确保满足 AI 和机器学习技术不断增长的需求。

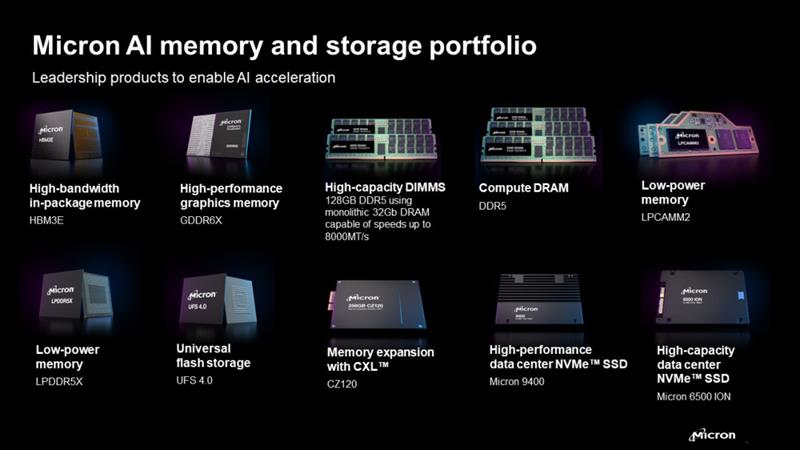

内存对于 AI 加速至关重要:美光对创新以及未来的愿景

信息图表:美光 AI 内存和存储产品组合(HBM3E、GDDR6X)。CXL、大容量 DIMM、DDR5、LPCAMM2、UFS 4.0 和数据中心 SSD。

内存对于 AI 的发展举足轻重,决定了 AI 学习、演进和融入人们生活的速度。在内存和存储层次结构中,每一层都发挥着关键作用。例如,近内存负责高速数据处理,主内存负责管理海量数据。同样,扩展内存可提供更多容量,SSD 数据缓存有助于快速访问,数据湖则提供基础的存储设备。所有这些层共同确保了 AI 应用的无缝运行。未来的 AI 将越发智能,而内存和存储将在 AI 发展过程中起到不可或缺的作用。为加速 AI 发展,必须持续创新并投资这些关键的半导体技术。

从 1978 年博伊西一家牙医诊所地下室里的初创企业,到如今内存和存储解决方案领域的全球知名厂商,美光展现了对创新和卓越的不懈追求。在超过 45 年的创新历程中,美光不断突破技术界限,包括开发全球最小的 256K DRAM、业界前沿的 1 内存节点和业界首款 232 层 NAND。

这些里程碑不仅是半导体制造领域的重要成就,也是推动 AI 革命向前发展的关键时刻。展望未来,我们认为,持续聚焦并投资内存和存储技术,对于充分发挥 AI 的潜力至关重要。美光对创新的承诺强调了这些技术在 AI 发展过程中的重要性,激励我们心怀谦逊、保持好奇心和远大目标,推动 AI 向前发展。美光的未来愿景是通过 AI 技术改善整个世界并丰富所有人的生活。这一愿景基于我们的价值观:关怀员工、创新为先、坚韧不拔、精诚合作、客户导向。我们坚信,技术能够而且应当成为带来积极改变的力量。我们将秉持这一信念继续前行。