TrendForce对HBM市场的最新研究显示,NVIDIA计划实现HBM供应商多元化,以实现更稳健、更高效的供应链管理。三星的 HBM3 (24GB) 预计将于今年 12 月完成 NVIDIA 的验证。HBM3e 的进展情况如下表所示,美光于 7 月底向 NVIDIA 提供了 8hi (24GB) 样品,8 月中旬向 SK 海力士提供,10 月初向三星提供。

鉴于 HBM 验证过程的复杂性(预计需要两个季度),TrendForce 预计一些制造商可能会在 2023 年底之前获悉 HBM3e 的初步结果。不过,普遍预计主要制造商将在 2024 年第一季度之前获得明确的结果。值得注意的是,最终评估仍在进行中,结果将影响 NVIDIA 2024 年的采购决策。

NVIDIA继续主导高端芯片市场,扩大其先进AI芯片阵容

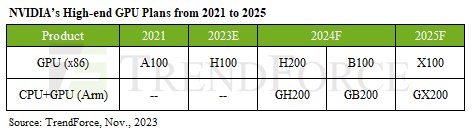

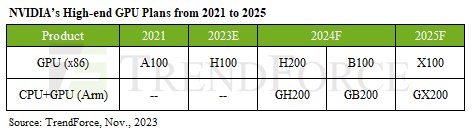

2024 年即将到来,多家 AI 芯片供应商纷纷推出最新产品。NVIDIA 目前的 2023 年高端 AI 系列采用了 HBM,包括 A100/A800 和 H100/H800 等型号。2024 年,NVIDIA 计划进一步完善其产品组合。新增加的产品包括使用 6 个 HBM3e 芯片的 H200 和使用 8 个 HBM3e 芯片的 B100。NVIDIA 还将集成自家基于 Arm 的 CPU 和 GPU,推出 GH200 和 GB200,通过更专业、更强大的 AI 解决方案增强其产品阵容。

相比之下,AMD 2024 年的重点是采用 HBM3 的 MI300 系列,下一代 MI350 过渡到 HBM3e。该公司预计将于 2H24 开始对 MI350 进行 HBM 验证,预计 25 年 1 季度产品将大幅增加。

Intel Habana 在 2H22 推出了 Gaudi 2,它采用了 6 个 HBM2e 堆栈。即将推出的 Gaudi 3(预计于 2024 年中期推出)预计将继续使用 HBM2e,但将升级至 8 个堆栈。TrendForce认为,NVIDIA凭借其最先进的HBM规格、产品准备和战略时间表,将在GPU领域保持领先地位,进而在竞争激烈的AI芯片市场保持领先地位。

HBM4 可能转向商品 DRAM 之外的定制

HBM4 预计将于 2026 年推出,具有针对 NVIDIA 和其他 CSP 未来产品量身定制的增强规格和性能。在更高速度的推动下,HBM4 将标志着其最底部逻辑芯片(基础芯片)首次使用 12 纳米工艺晶圆,由代工厂提供。这一进步标志着代工厂和存储器供应商之间针对每种 HBM 产品的合作努力,反映了高速存储器技术不断发展的前景。

随着更高计算性能的推动,HBM4 将从当前的 12 层 (12hi) 堆栈扩展到 16 层 (16hi) 堆栈,从而刺激对新混合键合技术的需求。HBM4 12hi 产品将于 2026 年推出,16hi 型号将于 2027 年推出。

最后,TrendForce 指出 HBM4 市场的定制需求发生了重大转变。买家正在启动定制规范,超越与 SoC 相邻的传统布局,并探索将 HBM?? 直接堆叠在 SoC 顶部等选项。虽然这些可能性仍在评估中,但 TrendForce 预计将针对 HBM 行业的未来采取更加量身定制的方法。

与商品 DRAM 的标准化方法相反,这种向定制化的转变预计将带来独特的设计和定价策略,标志着对传统框架的背离,并预示着 HBM 技术专业化生产时代的到来。

免责声明: 凡注明来源本网的所有作品,均为本网合法拥有版权或有权使用的作品,欢迎转载,注明出处。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。