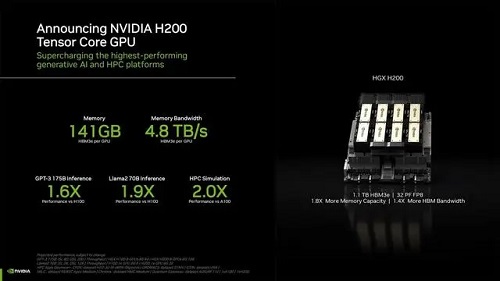

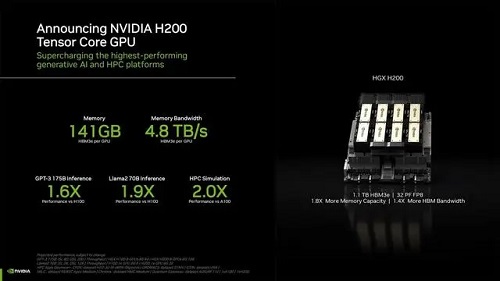

英伟达正式宣布,在目前最强AI芯片H100的基础上进行一次大升级,发布新一代H200芯片。H200拥有141GB的内存、4.8TB/秒的带宽,并将与H100相互兼容,在推理速度上几乎达到了H100的两倍。H200预计将于明年二季度开始交付,英伟达尚未公布其价格。

英伟达透露,下一代Blackwell B100 GPU也将在2024年推出,性能已经“望不到头”。

H200配备了141GB的HBM3e内存,运行速率约为6.25 Gbps,六个HBM3e堆栈为每个GPU带来4.8 TB/s的总带宽。原有的H100配备80GB的HBM3,对应的总带宽为3.35 TB/s,这是一个巨大的进步。相比于H100的SXM版本,H200的SXM版本将内存容量和总带宽分别提高了76%和43%。不过从原始计算能力来说,H200不会有太大的变化,只是在个别应用场景里会受益于更大的内存配置。

英伟达表示,根据使用Meta的70B大模型Llama 2进行的测试,H200的输出速度几乎是H100的两倍。基于与H100相同的Hopper架构,H200将具有H100的一切功能,例如可以用来加速基于Transformer架构搭建的深度学习模型的Transformer Engine功能。

毋庸置疑,与作为前辈的A100和H100相比,H200最大的变化就是内存。搭载“世界上最快的内存”HBM3e技术的H200在性能上得到了直接提升,141GB的内存几乎是A100和H100最高80GB内存的2倍,4.8TB每秒的带宽则达到了A100的2.4倍,也显著高于H100 3.35TB每秒的带宽。

来源:通信产业网

免责声明: 凡注明来源本网的所有作品,均为本网合法拥有版权或有权使用的作品,欢迎转载,注明出处。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。