因为人工智能等应用的火热,市场对HBM的需求水涨船高,但纵观这个市场,韩国的两家存储巨头三星和SK海力士正在成为这个市场唯二赢家。

近日,SK海力士更是带来了全新的HBM3E产品信息披露。这家制造商在一份关于验证该公司 1bnm 晶圆厂工艺的说明中首次表示,它正在研究下一代 HBM3E 内存,该内存将实现高达 8 Gbps/pin 的速度,并将在2024首次亮相.

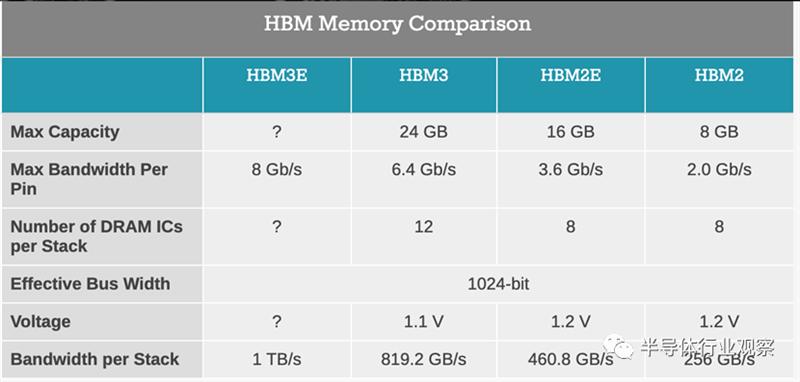

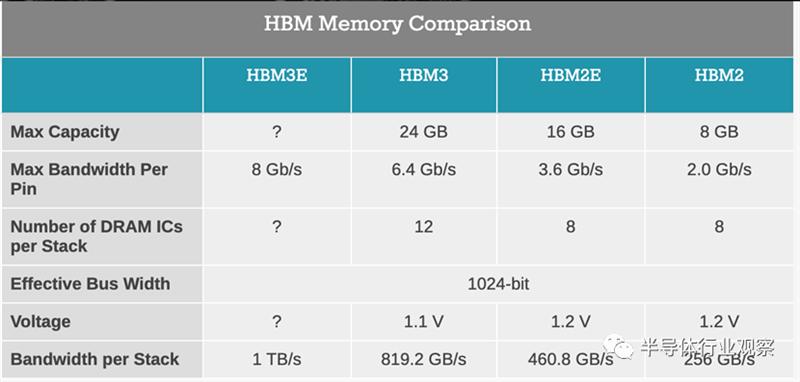

来自 SK Hynix 和其他供应商的当代 HBM3 内存支持高达 6.4Gbps/pin 的数据传输速率,因此具有 8 Gbpis/pin 传输速率的 HBM3E 将提供比现有存储设备 25% 的中等带宽优势。

将其放在上下文中,使用 1024 位宽内存总线的单个 HBM 堆栈,这将为 HBM3E 的已知良好堆栈裸片 (KGSD) 提供大约 1 TB/秒的带宽,高于HBM3当期那的 819.2 GB/秒。其中,现代 HPC 级处理器采用六个(或更多)堆栈,将为这些高端处理器计算出数 TB/秒的带宽。

根据该公司的说明,SK 海力士打算在未来几个月内开始对其 HBM3E 内存进行送样,并在 2024 年开始量产。内存制造商没有透露太多有关 HBM3E 的细节(事实上,这是第一次公开完全没有提到它的规格),所以我们不知道这些设备是否会直接兼容现有的 HBM3 控制器和物理接口。

假设 SK 海力士的 HBM3E 开发按计划进行,该公司应该可以轻松地让客户排队获得更快的内存。特别是随着用于构建 AI 训练和推理系统的 GPU 需求激增,NVIDIA 和其他处理器供应商更愿意为他们需要的高级内存支付高价,以便在这个行业繁荣时期生产更快的处理器。

SK 海力士将使用其1b纳米制造技术(第 5 代 10 纳米级节点)生产 HBM3E 内存,该技术目前用于制造 DDR5-6400 内存芯片,这些芯片将针对英特尔的下一代至强可扩展平台进行验证。此外,该制造技术将用于制造兼具高性能和低功耗的LPDDR5T存储芯片。

韩国双雄,遥遥领先 据韩媒businesskorea早前报道,自今年年初以来,三星电子和 SK 海力士的高带宽存储器 (HBM) 订单一直在激增。与其他 DRAM 相比,HBM 通过垂直连接多个 DRAM 显着提高了数据处理速度。它们与中央处理器(CPU)和图形处理器(GPU)协同工作,可以极大地提高服务器的学习和计算性能。

迄今为止,尽管 HBM 具有出色的性能,但与一般 DRAM 相比,其应用较少。这是因为 HBM 的平均售价 (ASP) 至少是 DRAM 的三倍。HBM 需要复杂的生产过程和高度先进的技术。人工智能服务的扩展扭转了局面。

全球最大的GPU公司Nvidia一直要求SK海力士提供最新产品HBM3芯片。全球第一的服务器CPU公司英特尔也在努力销售搭载SK海力士HBM3的产品。一位业内人士表示,“与最高性能的 DRAM 相比,HBM3 的价格上涨了 5 倍。”

随着高性能存储半导体市场有望快速增长,三星电子和 SK 海力士之间的产品开发竞争正在升温。HBM 市场仍处于初期阶段,因为 HBM 从 2022 年开始认真地进入 AI 服务器,但 SK 海力士和三星电子正专注于通过新产品发布来确保客户。

SK 海力士在 HBM 市场处于领先地位。它于 2013 年与 AMD 合作开发了世界上第一个 HBM。这家韩国芯片制造商已发布了第一代 HBM (HBM)、第二代 HBM (HBM2)、第三代 HBM (HBM2E) 和第四代 HBM (HBM3) 并已获得 60-70% 的市场份额。

2021 年 2 月,三星电子与 AMD 合作开发了 HBM-PIM,它将内存半导体和 AI 处理器合二为一。当在CPU和GPU上安装HBM-PIM芯片时,可以显著提高服务器的计算速度。SK 海力士还于 2022 年 2 月推出了采用 PIM 技术的产品解决方案。

中长期,专家预测,HBM等AI专用DRAM的开发,将给半导体行业带来巨大变革。“存储半导体公司忙于开发超微制造工艺的时代已经过去,”韩国半导体行业的一位官员表示。“高效处理数据甚至具备处理数据能力的AI半导体技术的发展将变得如此重要,它将决定芯片制造商的未来。

免责声明: 凡注明来源本网的所有作品,均为本网合法拥有版权或有权使用的作品,欢迎转载,注明出处。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。