由于人工智能尤其是生成式AI的广泛采用,未来几个季度和几年对高带宽内存的需求将呈爆炸式增长。根据 TrendForce 的数据,SK海力士很可能成为HBM反弹的主要受益者,因为它在这种类型的内存出货量中处于领先地位,到2022年占有50%的份额。

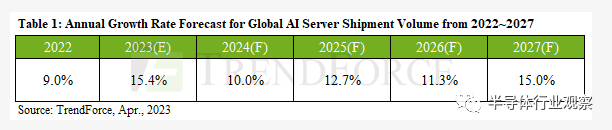

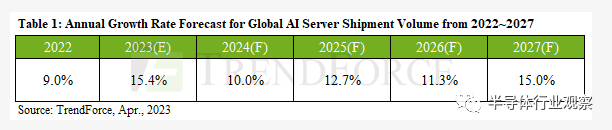

TrendForce 的分析师认为,到 2022 年,配备计算 GPU(如 Nvidia 的 A100 或 H100)的 AI 服务器的出货量将同比增长约 9%。但是,他们没有详细说明它们是指单位出货量还是美元出货量。他们现在估计,生成式人工智能的兴起将催化对人工智能服务器的需求,这个市场将在 2023 年增长 15.4%,并在 2027 年之前继续以 12.2% 的复合年增长率增长。

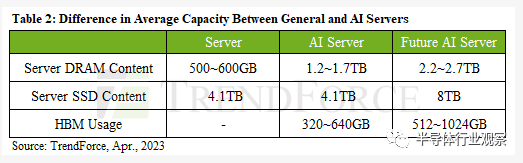

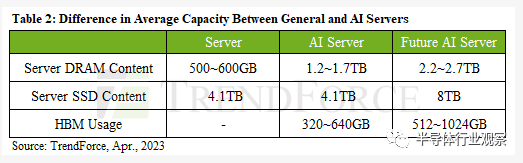

人工智能服务器使用的激增也将增加对所有类型内存的需求,包括商品 DDR5 SDRAM、HBM2e 以及用于计算 GPU 的 HBM3,以及用于高性能和大容量存储设备的 3D NAND 内存。

TrendForce 估计,虽然通用服务器包含 500 GB - 600 GB 的商品内存,但人工智能服务器使用 1.2 TB - 1.7 TB。此外,此类机器使用配备 80 GB 或更多 HBM2e/HBM3 内存的计算 GPU。由于每台 AI 机器都配备多个计算 GPU,因此每盒 HBM 的总容量现在为 320 GB – 640 GB,而且随着 AMD 的 Instinct MI300 和 Nvidia H100 NVL 等加速器搭载更多 HBM3 内存,它只会进一步增长。

说到 HBM3 的采用,需要注意的是,根据 TrendForce 的说法,SK 海力士是目前唯一量产这种类型内存的制造商。因此,随着对此类内存的需求增长,它将受益最大。去年,SK 海力士占据了 HBM 出货量的 50%,其次是三星,占 40%,美光占 10%。TrendForce 称,今年该公司将巩固其地位并控制 HBM 出货量的 53%,而三星和美光的份额将分别下降至 38% 和 9%。

如今,人工智能服务器主要由美国领先的云服务提供商使用,包括 AWS、谷歌、Meta 和微软。随着越来越多的公司推出他们的生成式 AI 产品,他们将不可避免地不得不使用本地或 AWS 或 Microsoft 的 AI 服务器。例如,百度和字节跳动计划在未来几个季度推出生成式人工智能产品和服务。

NVIDIA和英特尔抢购高速HBMChatGPT 和类似技术的出现为存储器制造商打开了新的商机。这样的系统处理大量数据并且需要用于服务器的高速组件。高带宽存储器 (HBM) 的需求越来越大,三星电子和 SK 海力士自今年年初以来已经收到了订单激增。

通过垂直连接多个内存芯片,与其他类型的 DRAM 相比,HBM 显着提高了处理速度。到目前为止,尽管性能出色,但 HBM 的使用比传统 DRAM 少。这是因为 HBM 的平均价格是传统 DRAM 的三倍。HBM 生产更加复杂且技术先进。然而,人工智能技术的发展可以力挽狂澜。

全球最大的计算用 GPU 制造商 NVIDIA 已与 SK 海力士接洽,为其提供最新产品 HBM3 芯片。作为全球最大的服务器处理器制造商,英特尔也在积极致力于推出搭载 HBM3 的产品。业内人士称,与最高性能的 DRAM 相比,HBM3 的价格上涨了五倍。

高性能内存模块市场预计将快速增长,三星和海力士之间的竞争将加剧。HBM 市场仍处于起步阶段,因为 HBM 直到 2022 年才开始在 AI 服务器中正式实施。

SK 海力士引领 HBM 市场。该公司于2013年与AMD合作开发HBM,这家韩国微芯片制造商推出了第一代(HBM)、第二代(HBM2)、第三代(HBM2E)和第四代HBM3模块,占据了60-70%的市场份额。

2021 年 2 月,三星与 AMD 合作开发 HBM-PIM,将存储芯片和 AI 处理器集成为一体。当 HBM-PIM 芯片与 CPU 和 GPU 协同工作时,可以大大加快计算速度。2022年2月,SK海力士还推出了基于PIM技术的解决方案。

专家预测,从中长期来看,HBM等人工智能存储器的发展将对半导体行业产生重大影响。负面趋势可能是设备成本增加。

编译自anandtech

免责声明: 凡注明来源本网的所有作品,均为本网合法拥有版权或有权使用的作品,欢迎转载,注明出处。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。